AI(人工知能)は、性能の良し悪しを決定する要素が数多くありますが、その中心にあるのが「パラメーター」です。特に、LLM(Large Language Models、大規模言語モデル)のような高度なAIシステムにおいて、パラメーターは極めて重要な役割を果たします。本記事では、パラメーターが何であり、LLMとパラメーターの関係がAIの性能にどのように影響を与えるのかを解説します。

WithAIメールマガジン登録(無料)

WithAIメールマガジンでは、生成AIの活用事例や、最新Newsから今すぐ使える実践ノウハウまで、

Webサイトではお届けしきれないさまざまなお役立ち情報を配信しています。ぜひご登録ください。

AIとパロメーター

LLM(大規模言語モデル)とは

LLMは、人間の言語を理解し、生成する能力を持つAI技術です。これらのモデルは、ウェブ上で利用可能な膨大なテキストデータから学習し、質問に回答したり、テキストを生成したりすることができます。その応用範囲は非常に広く、翻訳、要約、コンテンツ作成など、多岐にわたります。

パラメーターの役割と重要性とは

AIモデルの性能は、そのモデルがどれだけ人間の言語を正確に理解し、適切に反応できるかによって測られます。この性能を決定づける重要な要素がパラメーターです。パラメーターとは、モデルが学習過程で調整される変数のことを指し、これらがモデルの振る舞いを決定します。適切なパラメーターの設定は、AIモデルが与えられたタスクを効率的に、かつ正確に実行するために不可欠です。

パラメーターの概要

LLMは、パラメーターがモデルの学習能力と性能を左右します。この章では、パラメーターの概要、役割、そしてパラメーターとハイパーパラメーターの違いを詳しく解説します。

パラメーターとは

「パラメーター」とは、AIがデータから学んだり、判断したりする時に使う大切な情報のようなものです。例えば、人間が経験から学ぶように、AIもパラメーターを使って学習します。トレーニングを重ねるほど、AIはこのパラメーターを少しずつ調整して、より良い結果を出せるようになっていきます。簡単に言えば、パラメーターはAIの「頭の中」みたいなもので、これがAIの性能を左右する重要な要素となります。

AIモデルにおけるパラメーターの役割

AIモデルにおけるパラメーターの主な役割は、データから学習し、その学習をモデルの予測や判断に適用することです。例えば、テキストを生成するLLMでは、パラメーターは単語の選択や文の構成に関連する決定に影響を与えます。適切に調整されたパラメーターを持つモデルは、より人間に近い、自然な言語を生成することができます。

パラメーターとハイパーパラメーターの違い

パラメーターと混同されがちなのが「ハイパーパラメーター」です。ハイパーパラメーターは、モデルの学習プロセスを制御する外部変数であり、モデルのトレーニング前に手動で設定されます。これには、学習率やバッチサイズなど、モデルのトレーニング方法に影響を与える設定が含まれます。ハイパーパラメーターの適切な設定は、パラメーターの最適化と密接に関連し、最終的なモデルの性能を決定づけます。

パラメーターは、AIモデルの心臓部とも言える要素であり、モデルの学習能力と最終的な性能を決定します。適切に調整されたパラメーターを持つモデルは、与えられたタスクにおいて高い精度と効率性を発揮することができます。次の章では、LLMの構造とパラメーターについてさらに深く掘り下げ、その関係性と影響力について詳しく説明します。

LLMの構造とパラメーター

LLM(Large Language Models)は、自然言語処理において革新的な進歩を遂げた技術です。この章では、LLMの基本構造と、パラメーターがどのようにLLMの性能に影響を与えるかについて掘り下げます。

LLMの構造

大規模言語モデル(LLM)は、非常に複雑な構造を持つ人工知能システムです。これらのモデルは、数十億から数兆に及ぶパラメーターを有する巨大なニューラルネットワークで構成されています。

LLMの基盤となっているのは「トランスフォーマー」と呼ばれる技術です。この技術により、モデルは長文や複雑な文章を効率的に処理することができます。トランスフォーマーの核心となる機能は「自己注意機構」です。この機能を通じて、モデルは文章中の各単語の関係性を深く理解し、文脈に沿った自然な言葉の生成が可能となります。

このような高度な仕組みにより、LLMは人間の言語をより精密に理解し、適切な応答を生成することができるのです。

主要なLLMパラメーターの紹介

LLMのパラメーターは、主にモデル内の重みとバイアスから構成されています。これらのパラメーターは、モデルが学習データから情報を取得する過程で調整され、生成されるテキストの質に直接影響を与えます。一般的に、パラメーターの数が増えるほど、モデルはより複雑な言語パターンを学習し、より精度の高いテキストを生成する能力が向上します。

パラメーター数とAIモデルの性能の関係

パラメーター数は、LLMの能力を示す重要な指標の一つです。通常、パラメーター数が多いモデルは、より多くの情報を記憶し、より複雑な言語パターンを理解することができます。しかしながら、パラメーター数の増加に伴い、モデルの学習に必要な計算資源と時間も増大し、過学習のリスクも高まります。そのため、パラメーター数と性能の間には、適切なバランスを取ることが重要です。

LLMの構造とパラメーターは、その性能と応用範囲を決定づける重要な要素です。パラメーター数の増加は、モデルのより高度な言語処理能力につながる可能性がありますが、同時に学習の困難さも増します。適切なパラメーター設定と最適化は、LLMを効率的かつ効果的に活用するための鍵となります。

主要なLLMのパラメーターの紹介

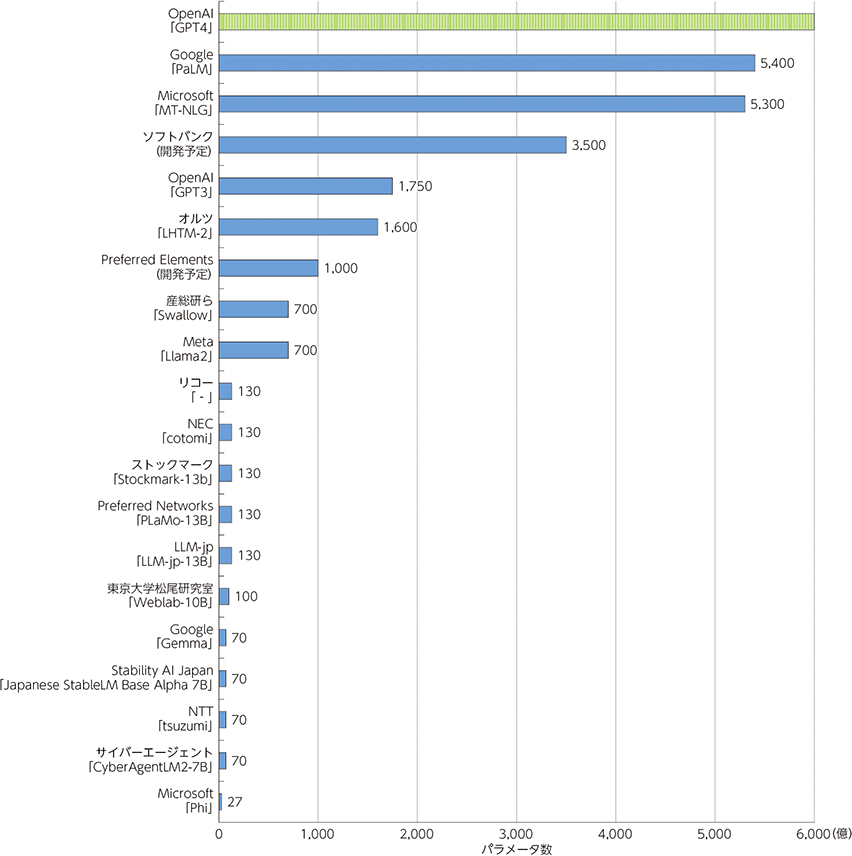

生成AIの基盤となる大規模言語モデル(LLM)の開発では、MicrosoftやGoogleなどの米国大手テクノロジー企業が先行している状況です。

しかし、日本以外の企業や研究機関が非公開で開発したLLMを利用するだけでは、LLM構築の過程が不透明になってしまい、LLM使用時の権利侵害や情報漏えいなどの懸念を払拭できません。日本語に強いLLMを安心して活用するためには、構築過程や使用データが明確で、透明性の高い国産LLMの開発が必要となります。

すでに日本企業の中にも、独自にLLM開発に取り組んでいる例があります。

海外の大手テクノロジー企業が開発したLLMと比較すると、日本では中規模のLLMが開発される傾向があります。これらの日本製LLMは、規模は小さいものの、日本語処理に特化した特徴を持っています。

主要なLLMのパロメーター比較

以下は主要なLLMのパロメータ数の比較表です。有名なChatGPTは学習トークン数がずば抜けて多いですが、あくまで性能に直結しているわけではないので、逆に最小のパロメーター数で最大限の性能を出すことができるLLMが最も優秀なLLMといえます。

引用:総務省https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/r06/html/nd141110.html

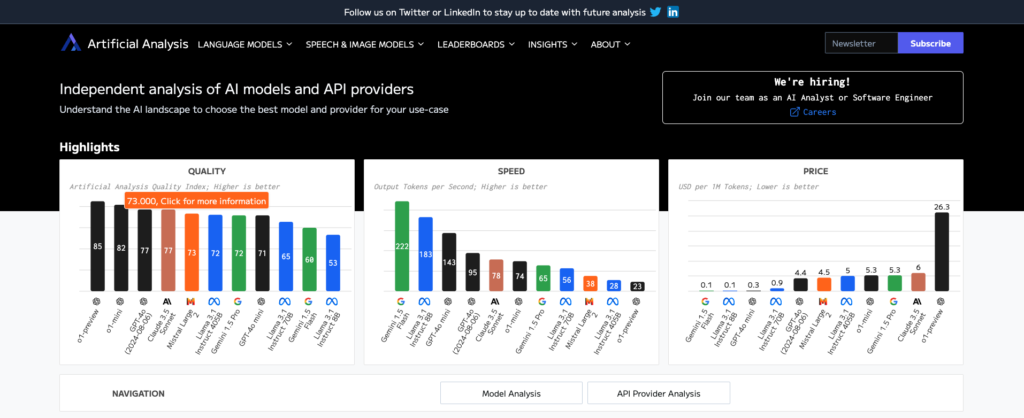

現在の各LLMの性能は『artificialanalysis.ai』というサイトで確認することができます。このサイトでは、出力の質、速度、価格などあらゆる視点からリアルタイムでLLMの比較を行なっているので、どのLLMを使用するのが最も適切なのかを瞬時に判断することができます。会員登録なども必要ないので、ぜひ活用してみましょう。

次章では、LLMとよく似た存在であるSLM(小規模言語モデル)について解説します。

SLMとは何か

SLMとは、Small Language Model(小規模言語モデル)の略称です。これは、大規模言語モデル(LLM)と比較して、より少ないパラメーター数で構築された言語モデルを指します。

SLMは、特定のタスクや領域に特化して設計されることが多く、一般的なLLMよりも効率的に動作することができます。また、計算リソースの制約がある環境や、特定の業務に特化したアプリケーションにおいて有用です。

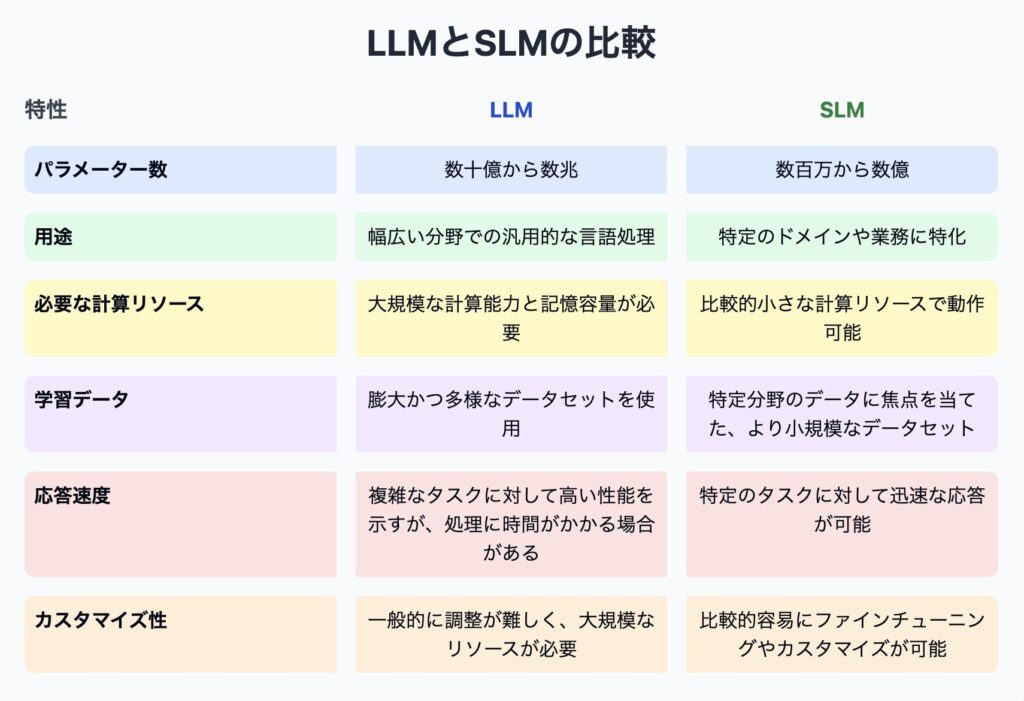

LLMとSLMの比較

LLMとSLMには、以下のような主な違いがあります:

SLMは、LLMと比較して規模は小さいものの、特定の用途においては効率的かつ効果的な選択肢となり得ます。企業や組織は、自身のニーズや利用可能なリソースに応じて、LLMとSLMを適切に選択することが重要です。

言語生成AIを使うなら『BizAI』がおすすめです。ChatGPT、Gemini、Claudeがたったの780円/月で全て使用できます。

また、用途に合わせたプロンプトが100種以上搭載されており、AIスキルなしで使用できます!

今だけ500チケット(約500出力分)を無料配布してるので、この機会にお試しください!

パラメーターがAI性能に与える影響

LLM(大規模言語モデル)の性能は、そのパラメーターによって大きく左右されます。この章では、パラメーター数が増加するとAIの性能がどのように変化するのか、また、パラメーターの最適化がどのように性能向上に寄与するのかについて解説します。

パラメーター数の増加が性能に及ぼす効果

パラメーター数が増加すると、モデルはより多くの情報を学習し、保持することができます。これは、モデルがより複雑な言語パターンを理解し、より自然で精度の高いテキストを生成する能力を持つことを意味します。例えば、GPT-3のようなLLMは、数百億のパラメーターを持ち、その結果、幅広い言語タスクにおいて人間に近いパフォーマンスを達成しています。

パラメーターの最適化と性能向上

ただし、パラメーター数を単純に増やすだけでは、必ずしもモデルの性能が向上するわけではありません。パラメーターの適切な最適化が重要です。最適化には、過学習を避けるための正則化技術、学習率の調整、損失関数の選択などが含まれます。これらの最適化手法を適切に適用することで、モデルはより一般化された学習を行い、未知のデータに対しても高い精度で予測を行うことが可能になります。

パラメーター調整の課題と限界

パラメーター調整は、計算コストが高く、時間を要するプロセスです。特に、パラメーター数が非常に多いLLMの場合、適切な値を見つけるためには膨大な量の計算リソースとトレーニングデータが必要になります。また、過剰なパラメーター最適化は、過学習のリスクを高め、モデルの汎用性を損なう可能性があります。

パラメーターはLLMの性能に直接影響を及ぼし、パラメーター数の増加はモデルの能力を向上させる可能性を秘めていますが、その最適化には注意が必要です。パラメーターの適切な調整と最適化は、高性能なAIモデルを構築するための鍵となります。次の章では、これらのパラメーターをどのように効果的に調整し最適化するか、その具体的な方法について掘り下げます。

LLMパラメーターの調整と最適化

LLM(大規模言語モデル)のパラメーターを適切に調整し、最適化することは、AIの性能を最大限に引き出す上で非常に重要です。このプロセスは、モデルが与えられたタスクに対して最高のパフォーマンスを発揮するようにするためのものです。この章では、効果的なパラメーター調整方法、自動パラメーター調整技術(AutoML)、および最適化の実際の事例について詳しく見ていきます。

効果的なパラメーター調整方法

パラメーター調整は、モデルの学習プロセスにおいて最も重要なステップの一つです。一般的な方法には、グリッドサーチ、ランダムサーチ、ベイジアン最適化があります。これらの手法は、ハイパーパラメーターの最適な組み合わせを見つけ出すために使用され、モデルの性能を向上させるための重要な手段となります。

- グリッドサーチは、あらかじめ定義されたパラメーターのグリッド上で、すべての組み合わせを試して最適なものを見つけ出す方法です。

- ランダムサーチは、パラメーター空間内でランダムに組み合わせを選択し、最適なものを探すより効率的な方法です。

- ベイジアン最適化は、過去の試行結果を利用して、次に試すべきパラメーターの組み合わせを推測する、より高度な方法です。

自動パラメーター調整技術(AutoML)

AutoMLは、モデルのパラメーター調整プロセスを自動化する技術で、AI開発の効率を大幅に向上させます。AutoMLツールは、最適なモデルアーキテクチャの選択、ハイパーパラメーターの調整、さらには特徴量のエンジニアリングまで、モデル開発の多くの側面を自動化することができます。この技術により、データサイエンティストやAI開発者は、より創造的な作業に集中することができるようになります。

最適化の事例紹介

- 事例1:Eコマース推薦システム – あるEコマースプラットフォームでは、AutoMLを使用して推薦アルゴリズムのパラメーターを最適化しました。これにより、顧客の購買履歴と行動データに基づいて、より精度の高い商品推薦が可能になり、売上が大幅に向上しました。

- 事例2:自然言語処理タスク – 国際的なニュース配信社が、ベイジアン最適化を用いてLLMのパラメーターを調整しました。この最適化により、ニュース記事の自動要約の品質が向上し、読者のエンゲージメントが高まりました。

パラメーターの効果的な調整と最適化は、LLMを含むAIモデルの性能を向上させるために不可欠です。AutoMLなどの自動化技術を活用することで、このプロセスの効率化が可能になり、より高度なモデルの開発が現実のものとなります。次の章では、LLMの未来と、パラメーターの進化がAI技術にどのような影響を与えるかについて見ていきます。

LLMの未来とパラメーターの進化

LLM(大規模言語モデル)の発展は、AI技術の将来において重要な役割を担っています。パラメーターの数と質の向上は、この進化の中心にあります。この章では、パラメーターの進化がLLMの未来にどのような影響を与えるか、そして企業や開発者がどのようにしてこれらの進歩に適応していくべきかについて探ります。

パラメーター数の増加がもたらす未来

パラメーター数の増加は、LLMがより複雑な言語パターンを理解し、より人間に近い自然言語生成を実現するための鍵です。将来的には、パラメーター数がさらに増加し、その結果、モデルの理解能力や生成能力も大幅に向上することが予想されます。これにより、自動翻訳、コンテンツ生成、対話システムなど、LLMの応用範囲はさらに広がります。

新しい技術トレンドとパラメーターの役割

LLMの発展に伴い、新しい技術トレンドが登場しています。例えば、より効率的なパラメーター学習アルゴリズム、パラメーターの圧縮技術、またはモデルの一部を動的に調整する手法などがあります。これらの進歩は、計算資源の制約を克服し、LLMをより幅広い環境で活用できるようにするために不可欠です。

持続可能な性能向上のためのアプローチ

パラメーター数の増加とそれに伴う性能向上は、計算コストの増大やエネルギー消費の問題を引き起こす可能性があります。持続可能な発展を実現するためには、効率的なパラメーター設計、省エネルギー型の計算アーキテクチャの開発、またはトレーニングプロセスの最適化など、新しいアプローチが求められます。

企業や開発者の対応策

LLMの未来とパラメーターの進化に適応するために、企業や開発者は以下のような対応策を考慮する必要があります。

- 継続的な教育:最新のAI技術とその応用に関する知識を常に更新し続ける。

- 技術的な柔軟性:新しいモデルやアルゴリズムに迅速に適応し、実験的なアプローチを恐れない。

- 倫理と持続可能性の考慮:技術の進化を倫理的かつ持続可能な方法で進めるための方針を策定する。

パラメーターの進化はLLMの未来を形作る重要な要素ですが、これに伴う挑戦も多く存在します。持続可能な発展と効率的な活用を実現する

ためには、企業や開発者が新しい技術トレンドに適応し、倫理的かつ環境に配慮したアプローチを取り入れることが重要です。このようにして、LLMのポテンシャルを最大限に活用し、未来のAI技術の進歩をリードしていくことができるでしょう。

パロメーターはLLMに欠かせない要素

この記事を通じて、LLM(大規模言語モデル)のパラメーターに焦点を当て、その基本概念から、AI性能に及ぼす影響、さらにはパラメーターの調整と最適化の方法に至るまで、幅広く掘り下げてきました。パラメーターは、LLMの性能を形成し、その応用範囲を拡大する上で中心的な役割を果たします。正しく理解し、自身がAIツールを選ぶときの反大材料として活用しましょう。

言語生成AIを使うなら『BizAI』がおすすめです。ChatGPT、Gemini、Claudeが全てたったの780円/月で使用できます!

また、用途に合わせたプロンプトが100種以上搭載されており、初心者にも優しい設計になっています!

今だけ500チケット(約500出力分)を無料配布してるので、この機会にお試しください!